(서울=뉴스1) 김정현 기자 = 정부가 '한국형 인공지능'(K-AI) 선발을 목표로 진행 중인 '독자 파운데이션 모델'(독파모) 프로젝트에서 잡음이 끊이지 않고 있다.

업스테이지 논란에 이어 이번엔 '옴니모달' AI 모델을 개발 중인 네이버(035420)가 AI 모델의 시각·청각 지능에 해당하는 기능과 데이터를 중국 모델에서 가져다 쓴 것이 논란이 일고 있다.

<뉴스1>이 업계 전문가와 함께 검증한 수치에 따르면 '하이퍼클로바X 시드 32B 싱크'의 비전 인코더 웨이트(가중치)는 중국 알리바바의 큐웬(Qwen) 2.5의 비전 인코더와 코사인 유사도 99.51%, 피어슨 상관계수 98.98% 이상의 수치를 보였다. 오디오 인코더는 피어슨 상관계수 100%가 나왔다.

코사인 유사도가 벡터의 방향을 비교하는 지표라면 피어슨 상관계수는 실제 데이터값의 분포가 얼마나 똑같은지를 따지는 지표다. 실제 데이터 유사성을 따질 때 사용된다.

검증에서 나온 수치를 보면 네이버는 큐웬 2.5의 비전 인코더를 파인 튜닝해 사용하고, 오디오 인코더는 그대로 가져다 쓴 셈이다.

이번 네이버 논란은 앞서 제기됐다 해소된 업스테이지 표절 논란과는 다소 결이 다르다.

업스테이지는 솔라 오픈 100B 모델 자체에 제기된 중국 지푸 AI의 'GLM-4.5-에어' 표절 논란에 공개검증을 통해 개발 이력과 학습 로그를 공개하며 반박했다.

업스테이지는 중국 모델의 가중치 재사용은 통계적 착시인 점을 설명했고, 두 모델의 피어슨 상관계수 분석 수치도 제시했다.

네이버는 모델 자체에 문제가 제기된 건 아니다. 그러나 옴니모달 AI의 핵심 요소 '인코더'와 가중치까지 중국 모델의 것을 쓴 점이 문제가 됐다.

인코더는 입력된 내용을 문맥화된 의미 표현(토큰)으로 변환하는 트랜스포머 기반 신경망 블록을 의미한다. 단순히 입력 내용을 변환하는 필터가 아니라 수천만 개 이상 파라미터로 구성된 이해 엔진이다.

텍스트뿐 아니라 이미지와 음성 입력까지 처리하는 옴니모달 AI에서 비전 인코더와 오디오 인코더는 단순 시각·청각 기관을 넘어 이를 처리하는 두뇌에 더 가깝다.

한 업계 전문가는 "실제로 멀티모달 대규모언어모델(MLLM)의 경우, 비전 인코더의 품질이 모델 성능의 상한선을 결정한다는 연구 결과도 있다"며 "특히 가중치까지 그대로 가져다 쓴 건 일반적인 프롬 스크래치 기준에 어긋날 걸로 보인다"고 지적했다.

네이버는 하이퍼클로바X 시드 32B 싱크 모델의 비전·오디오 인코더를 가져다 사용한 점은 인정했다. 다만 이는 멀티모달 AI 개발의 관행이라는 입장이다.

네이버클라우드 관계자는 "글로벌 AI 업계에서는 멀티모달 AI를 만들 때 이미 성능이 검증된 최상의 비전 인코더를 기반 모듈로 활용해 전체 모델의 멀티모달 커버리지를 효율적으로 극대화하는 것이 표준적인 엔지니어링 방식"이라고 설명했다.

이어 "네이버 역시 VUClip 등 독자적인 비전 인코더 기술력을 충분히 보유하고 있지만 이번 모델에서는 글로벌 최신 트렌드와의 호환성, 그리고 전체 시스템의 최적화를 위해 해당 인코더를 전략적으로 채택했다"고 덧붙였다.

다만 일각에서는 이같은 설명이 평소 자국 기술로 개발하는 '소버린 AI'를 강조해 온 네이버 측의 태도와 상반된다는 지적도 있다. 그간 하이퍼클로바X 개발을 담당하는 성낙호 네이버클라우드 하이퍼스케일 기술총괄은 '네이버가 소버린 AI의 원조'라는 점을 강조해 왔다.

익명을 요구한 한 업계 관계자는 "이번 독자 파운데이션 모델 프로젝트 자체가 소버린 AI를 표방하면서 시작됐는데, 이런 프로젝트에 효율성을 이유로 중국 모델의 기능을 파인튜닝하거나 그대로 가져다 쓴 게 적절한지 본질적인 부분에서 의문이 든다"며 "자체 기술이 있다면서도 중국 모델의 인코더를 사용한 건 자체 기술력이 부족한 점을 사실상 시인한 게 아니냐"고 꼬집었다.

이번 네이버 논란을 두고 정부의 교통 정리가 필요하다는 목소리도 커지고 있다. 경쟁을 통해 참여 기업들이 탈락하는 방식의 정책과제에서 명확하지 않은 '프롬 스크래치' 기준이 논란의 빌미를 제공했다는 지적이다.

프롬 스크래치는 AI 모델을 만들 때 기초적인 아키텍처부터 모두 직접 설계하고 개발하는 걸 말한다. 그러나 실제 현업에서는 AI 개발 방식이 복잡해지며 '프롬 스크래치'라는 용어가 마케팅적으로 활용되는 경우도 적지 않다.

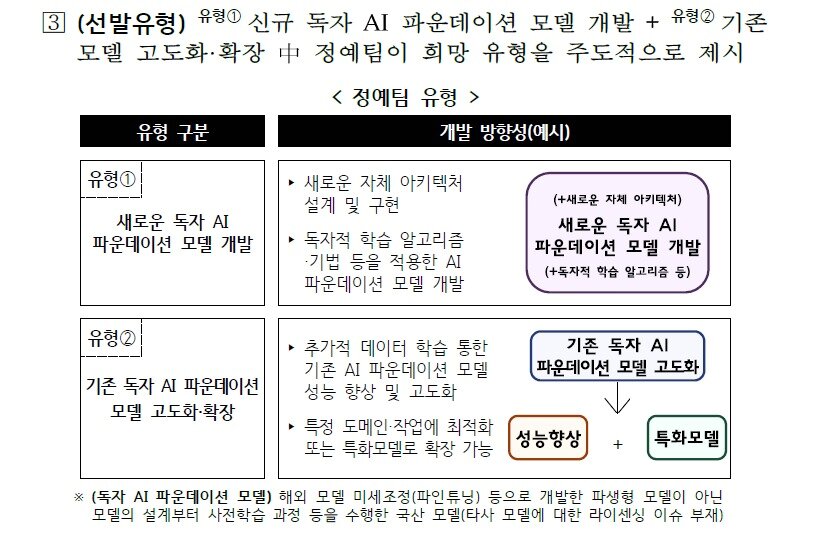

정부의 이번 독파모 사업 공고도 프롬 스크래치의 명확한 기준을 제시하지 않았다.

사업공고에 따르면 정부가 선발하는 '독자 AI 파운데이션 모델'의 정의는 해외 모델의 미세조정(파인튜닝) 등으로 개발한 파생형 모델이 아닌 모델의 설계부터 사전학습 과정 등을 수행한 국산 모델이다. 타사 모델의 라이센싱 이슈도 없어야 한다고만 했다.

네이버의 경우 파운데이션 모델은 100% 자체 기술로 개발했다고 하지만, 비전·오디오 인코더와 함께 가중치를 거의 그대로 가져다 썼기 때문에 향후 라이센싱 문제가 발생할 가능성이 '0'는 아닌 상황이다.

Kris@news1.kr

![[르포]"휘두른 창검의 손맛, 용의 날개짓" 붉은사막 제작현장 가다](https://image.news1.kr/system/photos/2026/2/24/7765279/no_water.jpg/dims/crop/628x439)