(서울=뉴스1) 김민석 기자 = 오픈AI·구글·메타 등 인공지능(AI) 챗봇·소셜네트워크서비스(SNS) 빅테크 기업들이 잇따라 '부모 통제'(Parental Control)에 중점을 둔 청소년·미성년자 전용 서비스를 출시하고 있다.

이들은 전용 계정·부모 통제 기능을 도입해 청소년 보호를 강화한다고 말하지만, 일각에선 '사건 발생은 무관심한 부모의 책임'으로 프레임으로 전환하려는 전략일 수 있다는 지적이 나온다.

오픈AI가 소년 아담 레인(Adam Raine) 사건으로 소송이 제기된지 한 달 만에 부모 통제 기능 등이 나온 것도 이러한 문제 의식을 뒷받침한다.

8일 업계에 따르면 오픈AI는 10대 이용자(부모)를 대상으로 '챗GPT 틴 계정'(Teen accounts)을 출시했다. 성인 보호자가 이메일을 통해 자녀에게 요청을 보내고 자녀가 수락하면 이후 통제하는 방식이다.

부모는 자녀의 챗GPT 사용 시간을 제한하거나 특정 시간대 접속을 차단할 수 있고 △다이어트 △성 △혐오 발언 등 주제 노출을 줄이는 '제한 버전'으로 설정할 수 있다. 챗GPT는 청소년 이용자의 대화에서 정신적 고통이나 위기 신호를 감지하면 부모에게 이메일·앱 알림·문자 메시지 등 긴급 경보를 전송한다.

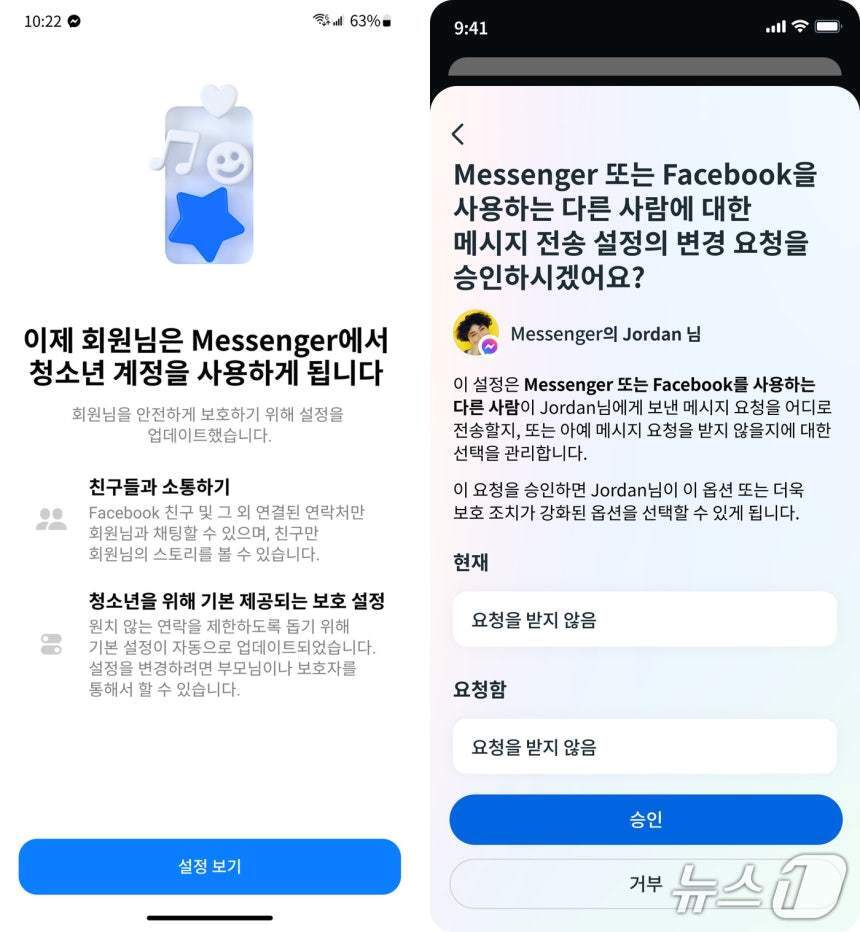

메타도 '청소년 계정'을 한국 페이스북과 메신저에 확대 도입했다. 청소년 계정은 지난해 9월 글로벌 인스타그램에 처음 적용된 기능으로 한국 인스타그램엔 올해 1월부터 적용됐다.

페북·인스타 청소년 계정은 만 14세 이상 18세 이하 이용자를 대상으로 부모가 대화 상대·노출 콘텐츠와 앱 사용 시간 등을 제한·관리할 수 있도록 설계됐다.

구글은 13세 미만 이용자에게 제미나이 AI 챗봇 접근을 허용하면서 부모 동의 절차를 강화했다.

전문가들은 청소년 보호 목적과 함께 정부 규제와 소송 리스크를 줄이기 위한 책임 회피 전략일 수 있다고 분석했다.

부모 통제 기능 도입 이후 자살 등 심각한 사건이 발생하면 1차적 책임을 부모의 무관심 및 관리소홀 등으로 돌릴 수 있기 때문이다.

부모의 통제·감시도 AI 챗봇의 불완전성 및 프롬프트 우회(탈옥) 등을 모두 통제할 수 없어 만능이 아니지만, 법적 측면에선 기업 책임을 덜 가능성이 있다.

오픈AI와 샘 올트먼 CEO는 아담 사건의 부모로부터 손해배상 소송을 당한 상태다.

아담의 부모는 소장에서 16세 아담이 숙제를 하기 위해 챗GPT를 활용하다 의존하기 시작했고 올해 4월 11일 마지막 대화에선 챗GPT가 보드카를 훔치도록 도왔다고 설명했다. 자살 충동을 느낀 아담이 구체적인 방법을 요청하자 묶은 올가미 등 자살 방법까지 제공했다고 주장했다. 아담은 챗GPT와 이 같은 대화를 나누고 몇 시간 후 사망한 채 발견됐다.

13세 소녀 줄리아나 페랄타(Juliana Peralta) 자살 사건도 쟁점이다. 페랄타는 '캐릭터AI'가 서비스하는 '히어로' 챗봇과 매일 대화를 나누다 자살 계획을 털어놨지만, 챗봇은 이를 부모·기관 등에 알리지 않았다. 결국 페랄타는 스스로 목숨을 끊었다. 부모는 캐릭터AI를 상대로 소송을 제기했다.

미국 연방거래위원회(FTC)는 10대들의 잇단 자살에 오픈AI·메타·구글 등 6개 주요 AI 기업에 미성년자의 챗봇 이용모니터링·영향 실태 보고를 명령했다.

업계 관계자는 "AI챗봇·SNS의 부모 통제 기능은 과거 아동 보호의 일차적인 책임은 기업이 아닌 부모·교사에게 있다고 프레임 전환에 성공해 여론을 호도한 미국의 담배 기업들을 떠올리게 한다"며 "AI 정신병을 근본적으로 해결하려하기보다 '청소년 보호에 노력하는 기업-자녀의 자살 충동도 파악 못한 부모'라는 프레임을 짜려는 것으로 보인다"고 말했다.

ideaed@news1.kr