KAIST-이화여대, 영상 속 '트리거' 포착하는 AI 기술 개발

- 김종서 기자

(대전충남=뉴스1) 김종서 기자 = '카메라가 다른 곳을 비추는 사이 사라지는 물체는 무엇인가'라는 복잡한 질문에 인공지능(AI)은 실제 상황을 보고 판단하지 않고 언어 패턴에 의존해 그럴듯한 답을 추측하는 문제가 있다.

국내 연구진이 이 한계를 해결하기 위해 영상 속 '딱 중요한 순간(트리거 모먼트)'을 AI가 스스로 찾아내도록 하는 기술을 개발했다.

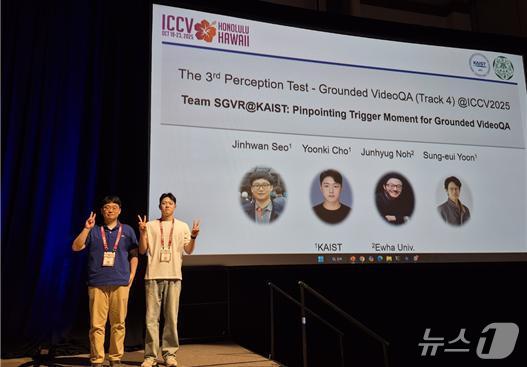

한국과학기술원(KAIST)은 전산학부 윤성의 교수 연구팀이 이화여대 노준혁 교수 연구팀과 공동 연구를 통해 국제 컴퓨터 비전 학회(ICCV 2025)에서 열린 인지 테스트 대회(Perception Test Challenge) 영상 근거 기반 질의응답 트랙에서 1위를 차지했다고 28일 밝혔다.

이번 학회에서 열린 인지 테스트 대회는 구글 딥마인드가 주관해 총 상금 5만 유로(한화 약 8300만 원)가 걸린 대회로, 영상·음성·텍스트 등 다양한 데이터를 종합적으로 이해하는 멀티모달 AI의 인지 및 추론 능력을 평가한다.

특히 언어 중심 편향을 벗어나 실제 영상 근거를 바탕으로 판단하는 능력이 핵심 평가 요소다.

KAIST 연구팀은 영상 전체를 무작정 분석하는 기존 방식과 달리, AI가 정답을 위해 꼭 필요한 핵심 장면을 먼저 찾아내도록 만드는 프레임워크 'CORTEX'를 개발했다. '이 질문에 답하려면 이 장면이 결정적이다'를 AI가 스스로 찾아내도록 설계한 기술이다.

연구팀의 시스템은 서로 다른 기능을 수행하는 세 모델이 순차적으로 작동하는 3단계 구조로 구성된다. 먼저 추론 AI가 질문에 답하기 위해 어느 순간을 봐야 하는지 사고하고 '딱 그 순간' 후보를 찾는다. 다음으로 객체 위치 찾기 모델이 해당 순간 화면 속 사람·차·사물의 정확한 위치(좌표)를 파악한다. 마지막으로 추적 모델이 선택된 한 장면을 기준으로 앞뒤 시간대의 객체 움직임을 정밀하게 추적해 오류를 줄인다.

즉 '핵심 장면 한 컷을 정확히 찍고 그 장면을 중심으로 정답 근거를 추적하는 방식' 덕분에 영상 초반 오판이나 가려짐 같은 문제도 크게 줄일 수 있다.

총 23개 팀이 참여한 영상 근거 기반 질의응답 트랙에서 KAIST팀은 '고차 추적 정확도(HOTA)' 지표에서 0.4968점을 기록하며 2위에 오른 미국 컬럼비아대(0.4304점)를 압도적인 점수 차로 누르고 1위를 차지했다. 이는 전년도 우승 기록(0.2704점)보다도 약 2배에 가까운 성과다.

이 기술은 실생활에서도 넓게 쓰일 수 있다. 자율주행차는 사고 위험이 있는 순간을 정확히 보고 로봇은 주변 상황을 더 똑똑하게 이해한다. 또 보안·감시 시스템은 중요한 장면을 빠르게 찾아내고 미디어 분석에서는 사람이나 사물의 행동을 시간 순서대로 정확히 추적할 수 있다.

AI가 '영상 속 실제 근거'를 보고 판단할 수 있도록 만드는 핵심 기술이다. 특히 영상 속 객체가 시간에 따라 어떻게 행동하는지 정확히 짚어내는 능력은 향후 AI의 실제 현장 적용을 크게 확장할 것으로 기대된다.

이번 연구는 ICCV 2025에서 발표됐다.

jongseo12@news1.kr

Copyright ⓒ 뉴스1. All rights reserved. 무단 전재 및 재배포, AI학습 이용금지.